ラズパイで物体検出の高速化にチャレンジ!!

こんにちは。

AI coordinatorの清水秀樹です。

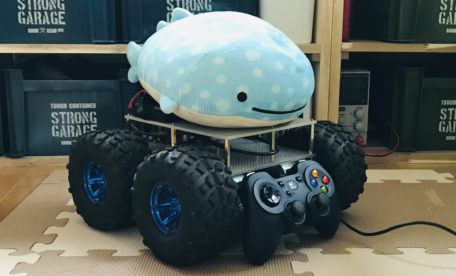

いよいよラズパイを使った物体検出の高速化にチャレンジします。

以前ご紹介したSSD_Kerasを使ったラズパイでの物体検出は処理速度が大変遅く、実用化には程遠い感じでした。

またMvidiusのセットアップ時に使ったsampleは物体検出ではなく、画像認識でした。

そこで今回はいよいよ「PROTECT KIDS」の視覚部分の本格開発の足掛りとする、ラズパイでの物体検出の高速化にチャレンジしていきたいと思います。

環境準備

それでは初めていきましょう。

ラズパイでMovidiusのセットアップが終わっているところからスタートとなります。

Movidiusのセットアップは以下のページを参考にしてください。

だいたい5時間くらいかかります。

Movidiusが動く状態になったら、まずはYoloNCSをダウンロードしましょう。

以下のコマンドでダンロードします。

$ git clone https://github.com/gudovskiy/yoloNCS.git

続いて、学習モデルを保存するフォルダを作成しましょう。

$ mkdir -p ~/yoloNCS/weights

学習モデルはyolo_tiny.caffemodelを使用します。

172MBあります。

ダウンロードが完了したら、上記で作成したweightsフォルダ内に保存しましょう。

学習モデルの保存が完了したら、以下のコマンドでgraphバイナリーファイルを作成します。

$ cd yoloNCS $ mvNCCompile prototxt/yolo_tiny_deploy.prototxt -w weights/yolo_tiny.caffemodel -s 12

あとは実行するだけです。

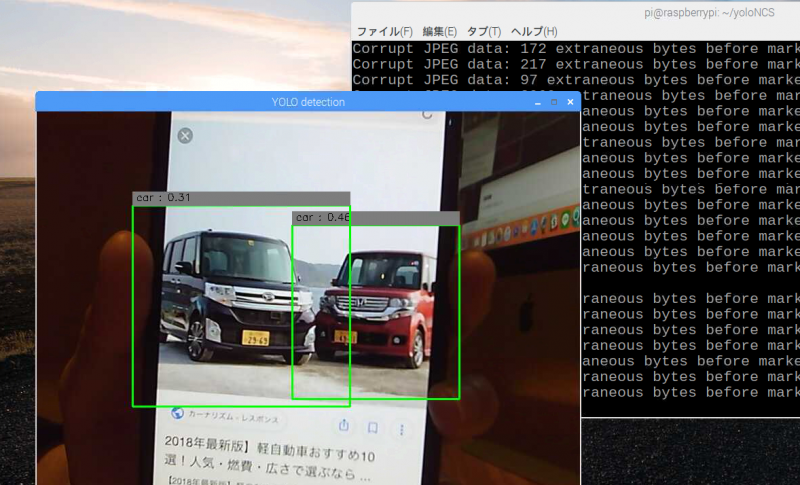

$ python3 py_examples/object_detection_app.py

無事カメラ映像が表示できれば成功です。

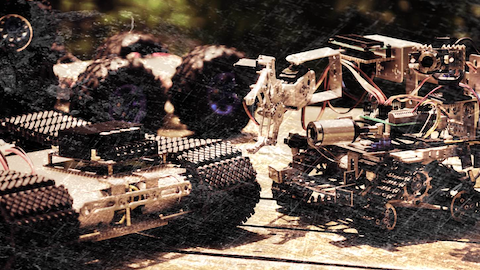

考察

処理スピードはいくらかマシになった程度ですが、Movidiusがないときに比べればはるかにマシですね。

ただ、遅れもあるのでリアルタイムを求めるとなると、もう少し工夫が必要そうです。

本日はここまで。

それではまた。

その他のPROTECT KIDS開発記事はこちら

その他のPROTECT KIDS開発記事はこちら

この記事へのコメントはありません。